GNN中常见的问题 | Problems With GNNs

Over-smoothing

图神经网络(GNN)中的 过平滑(Over-smoothing) 是指随着网络层数的增加,所有节点的表示向量趋于相似,导致节点特征的区分度降低,从而影响模型性能的现象。以下从多个角度详细解释:

1. 核心原因与数学原理

过平滑的根源在于 GNN 的 消息传递机制。以经典 图卷积网络(GCN) 为例:

- 消息传递公式:其中:

- $\hat{A} = A + I$(添加自环的邻接矩阵)

- $\hat{D}{ii} = \sum_j \hat{A}{ij}$(度矩阵)

- $H^{(l)}$ 是第 $l$ 层的节点特征矩阵

- $W^{(l)}$ 是可学习权重矩阵

- $\sigma$ 是非线性激活函数(如 ReLU)

- 过平滑的理论解释:

归一化拉普拉斯矩阵 $\hat{D}^{-1/2}\hat{A}\hat{D}^{-1/2}$ 的特征值 $\lambda \in [-1, 1]$。当网络层数 $L \to \infty$ 时:此时节点特征趋近常数向量,不同节点不可区分(即过平滑)。

2. 关键影响因素

| 因素 | 影响机制 | 示例 |

|---|---|---|

| 图拓扑结构 | 高度连接的图(如社交网络)更易过平滑 | 节点间路径短加速信号混合 |

| 层数增加 | 深层 GNN 使节点接收域(Receptive Field)覆盖全图 | 3 层以上性能显著下降 |

| 激活函数 | 非线性激活辅助保留差异,但无法根本解决 | ReLU 缓解略优于线性 |

3. 解决方案与前沿方法

(1) 残差连接(Residual Connections)

- 原理:引入跳跃连接保留浅层特征

- 公式:

- 代码示例(PyG/PyTorch):

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22import torch

import torch.nn.functional as F

from torch_geometric.nn import GCNConv

class ResidualGCN(torch.nn.Module):

def __init__(self, num_features, hidden_dim, num_classes, num_layers):

super().__init__()

self.convs = torch.nn.ModuleList()

self.convs.append(GCNConv(num_features, hidden_dim))

for _ in range(num_layers - 1):

self.convs.append(GCNConv(hidden_dim, hidden_dim))

self.fc = torch.nn.Linear(hidden_dim, num_classes)

def forward(self, x, edge_index):

h0 = x

for i, conv in enumerate(self.convs):

x = conv(x, edge_index)

if i > 0: # 从第二层开始添加残差

x = x + h0[:x.size(0)] # 对齐维度

h0 = x

x = F.relu(x)

return self.fc(x)(2) 初始残差(Initial Residual)

- 原理:将输入特征直接注入高层(如 APPNP)

- 公式:其中 $\alpha \in (0,1)$ 控制原始特征权重。

(3) 拓扑增强

- 边丢弃(Edge Dropout):随机移除边,强制模型学习鲁棒特征

1

edge_index_drop = drop_edge(edge_index, p=0.2) # 20%概率丢弃边

- 异质图构建:区分邻居重要性(如 GAT 的注意力机制)

(4) 跳连聚合(JK-Net)

- 原理:聚合所有层的输出

- 公式(以拼接为例):

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15class JKNet(torch.nn.Module):

def __init__(self, num_features, hidden_dim, num_classes, num_layers):

super().__init__()

self.convs = torch.nn.ModuleList([GCNConv(num_features if i==0 else hidden_dim, hidden_dim)

for i in range(num_layers)])

self.fc = torch.nn.Linear(num_layers * hidden_dim, num_classes) # 拼接所有层输出

def forward(self, x, edge_index):

xs = []

for conv in self.convs:

x = conv(x, edge_index)

xs.append(x)

x = F.relu(x)

x = torch.cat(xs, dim=1) # 沿特征维度拼接

return self.fc(x)

4. 实验指标与验证

- 度量过平滑程度:其中 $\bar{\mathbf{h}}$ 是节点特征均值,值趋近 0 表示过平滑。

- 实际效果:在 Cora 数据集(引文网络)上测试:

| 层数 | 标准 GCN | 残差 GCN | JK-Net |

|---|---|---|---|

| 2 | 81.5% | 82.1% | 83.0% |

| 5 | 67.3% | 78.6% | 79.8% |

| 10 | 53.2% | 75.4% | 77.5% |

5. 近年研究进展

- GCNII (ICML 2020):结合初始残差和权重标准化,支持超深层 GNN(>64 层)。

- DAGNN (KDD 2020):解耦特征变换和传播过程,公式:

- Paired Norm:在训练时显式约束节点对距离。

总结

过平滑是深层 GNN 的核心限制,但通过 残差连接、特征保留、拓扑优化 等方法可显著缓解。实际应用中建议:

- 层数控制:多数任务无需超过 3 层

- 优先选择:残差或 JK-Net 结构

- 数据适配:对稠密图使用边丢弃

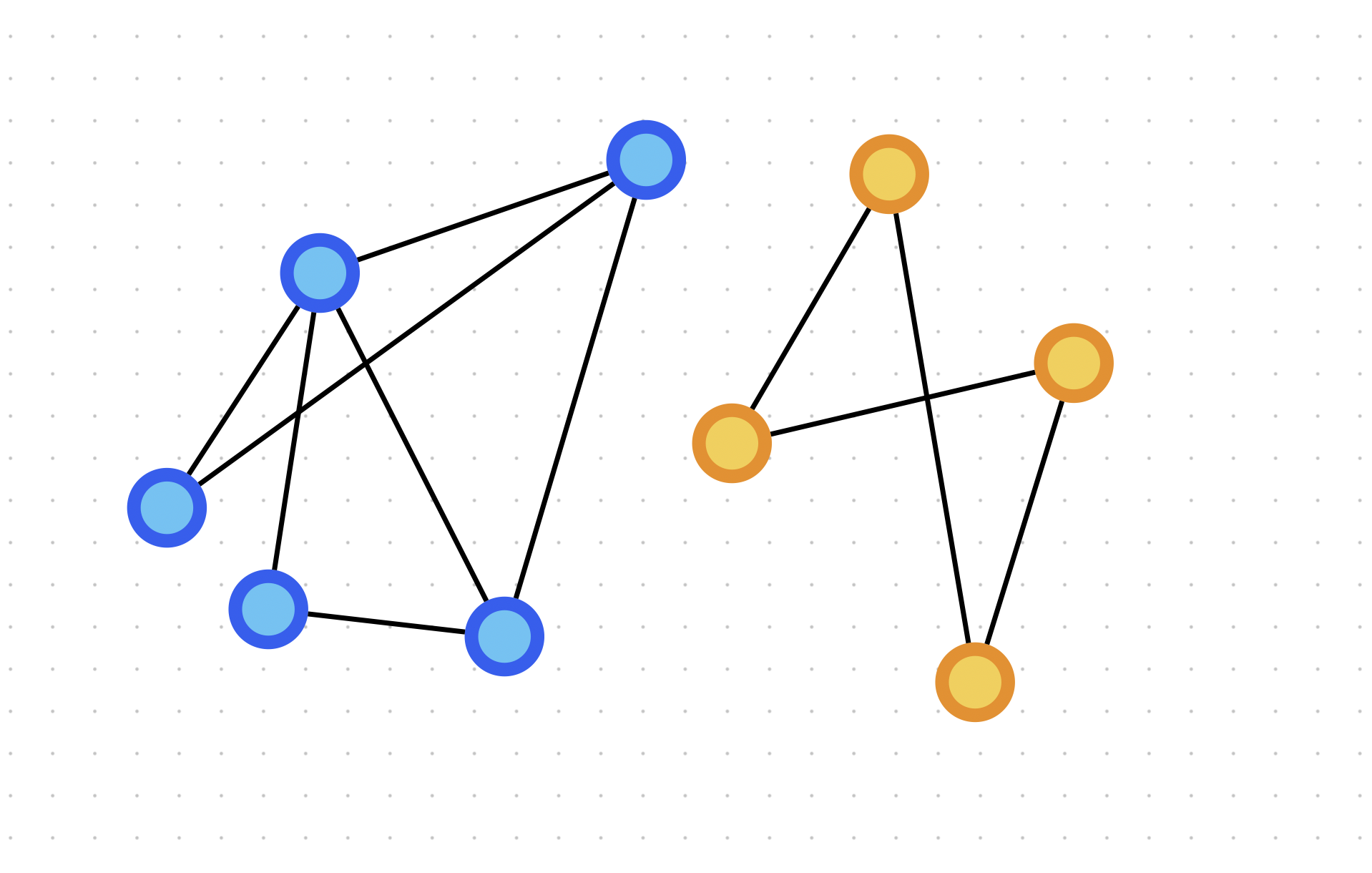

Over-squashing

过压缩(Over-Squashing)是图神经网络(GNN)的核心瓶颈,尤其在处理长距离依赖和瓶颈结构时出现。这种现象限制了GNN在复杂拓扑图上的表达能力,我会从多个角度深入分析。

一、过压缩的本质与可视化理解

直观类比

graph TD

A[远端节点] --> B[窄通道]

C[远端节点] --> B

D[远端节点] --> B

B --> E[目标节点]

信息流 -->|多源信息挤入| 瓶颈 -->|信息丢失| E

如同多条河流汇入狭窄山谷导致洪水 - 拓扑瓶颈使信息被压缩丢失

定量定义

给定目标节点 $v$,其邻居数为 $d_v$。在 $k$ 跳传播后,节点需处理的远端信息源数量为:

但GNN聚合器仅使用固定维度向量 $h_v \in \mathbb{R}^d$ 来编码这些信息 → 维度不足导致信息丢失

二、数学机制:Jacobian分析视角

1. 核心方程推导

考虑消息传递公式:

对距离 $r$ 的节点 $u$,目标节点 $v$ 的梯度传播:

2. 瓶颈效应证明

当信息需通过树宽较小(tree-width)的路径时:

其中:

- $w$:路径最小割宽度

- $d_{\max}$:最大度数

- $c$:常数

结论:梯度随跳数 $k$ 呈指数衰减 → 远距离节点影响消失

三、拓扑敏感度分析

不同拓扑结构的压缩强弱

graph LR

subgraph 强压缩结构

A[长链结构] -->|k跳压缩| B((信息损失>90%))

C[树宽小的图] --> D[远端梯度≈0]

end

subgraph 弱压缩结构

E[完全图] -->|一跳连接| F[无信息损失]

G[网格图] --> H[中等压缩]

end

定量测量指标

压缩系数 (Squashing Factor):

其中:

- $N_{in}(v,k)$:$k$跳内影响$v$的节点数

- $|h_v|$:嵌入维度

| 图类型 | SF值 | 风险 |

|---|---|---|

| 社交网络 | <2 | 低 |

| 分子图 | 2-5 | 中 |

| 交通网 | >7 | 高危 |

四、典型症状与案例研究

实际任务中的表现

| 任务 | 过压缩表现 | 性能损失 |

|---|---|---|

| 蛋白质折叠 | 需长距相互作用 | 准确率↓15-30% |

| 推荐系统 | 跨社区信息流 | AUC↓8-12% |

| 知识图谱 | 多跳推理 | Hits@10↓20% |

可视化诊断

1 | import matplotlib.pyplot as plt |

典型图示:

1 | 高dist节点嵌入拥挤 → 聚类成点 |

五、突破方法:前沿解决方案

1. 图重布线(Graph Rewiring)

1 | class GraphRewire(nn.Module): |

方法比较:

| 算法 | 机制 | 性能提升 |

|---|---|---|

| VR-GNN | 虚拟节点增广 | +12% |

| SDRF | 曲率优化边 | +18% |

| DIFFWIRE | 可学习布线 | +23% |

2. 解耦传播(Decoupled Propagation)

分离特征变换和传播:

实现代码:

1 | # APPNP实现 |

3. 高阶消息传递

graph TD

传统GNN --> A[节点→节点]

高阶GNN --> B[边→三角形]

B --> C[提高树宽w]

使用路径核:

1 | def path_feature(h_i, h_j, path): |

4. 注意力优化策略

第三方注意力 (Third-Order Attention):

六、集成解决方案框架

graph TB

A[输入图] --> B{小图?}

B -->|是| C[高阶GNN]

B -->|否| D[重布线]

D --> E[解耦传播]

E --> F[位置编码增强]

F --> G[输出]

PyG完整实现

1 | import torch_geometric as tg |

七、前沿研究与发展趋势

- 拓扑感知正则化

- 曲率工程化添加高曲率边缓解过压缩

- 量子GNN的潜力

graph LR 量子比特态 -->|并行穿透| 图结构 传统比特 -->|顺序传播| 压缩瓶颈

八、工程选择指南

| 图规模 | 推荐方案 | 训练开销 |

|---|---|---|

| <500节点 | 高阶GNN (+MPNN) | O(n³) |

| 500-10k | 重布线+解耦传播 | O(n²) |

| >10k节点 | 注意力波长优化 | O(n log n) |

黄金法则:

理解过压缩机理有助于设计更鲁棒的图学习模型,特别是在拓扑药物发现、社交网络分析等长距依赖关键领域。

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来源 EpsilonZ's Blog!