异质图数据集加载 | Heterogeneous Graph Features

异构图神经网络节点特征加载机制

一、核心挑战分析

| 挑战类型 | 具体表现 | 影响程度 |

|---|---|---|

| 特征异构性 | 节点属性维度/类型不一致 | ⭐⭐⭐⭐⭐ |

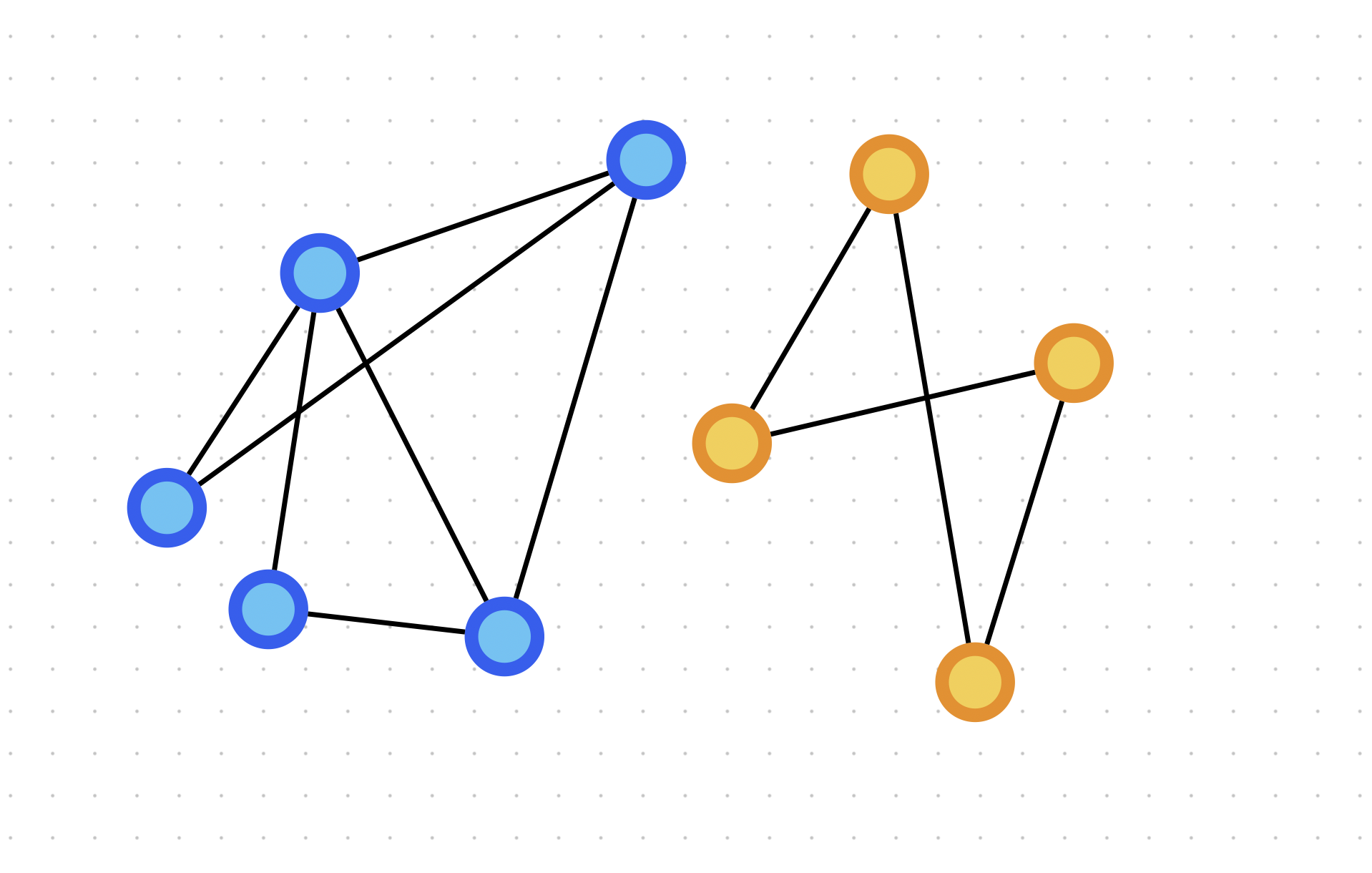

| 结构异构性 | 邻居节点类型多样性 | ⭐⭐⭐⭐ |

| 语义融合 | 多模态特征对齐困难 | ⭐⭐⭐⭐ |

二、关键技术方案解析

1. 特征空间统一化方法

graph LR

A[原始节点特征] --> B{节点类型判断}

B --> C[类型1投影层]

B --> D[类型2投影层]

C --> E[统一特征空间]

D --> E

E --> F[特征融合模块]

关键技术:

- 零值填充策略:为缺失特征维度自动补零

- 共享权重机制:跨类型节点的投影层参数共享

- 默认值规范化:通过非零比例调整权重分配

2. 异构特征融合技术

主要技术路线对比

| 方法 | 代表模型 | 优势 | 局限 |

|---|---|---|---|

| Kronecker积融合 | BG-HGNN | 保留高阶交互信息 | 计算复杂度高 |

| 注意力聚合 | HetGNN | 动态加权邻居 | 需要大量训练数据 |

| 区域特征提取 | HGNN-BRFE | 缓解过平滑问题 | 需预定义区域划分 |

| 元学习框架 | Meta-HGNN | 处理动态特征缺失 | 训练时间较长 |

3. 典型特征处理管道

1 | class HeteroFeatureProcessor: |

4. 前沿进展

- 动态特征加载:Meta-HGNN提出的在线特征补全机制

- 多模态融合:基于跨模态注意力(如文本+图像节点)

- 联邦特征学习:在不共享原始特征情况下的协同训练

三、工程实践建议

特征预处理阶段:

- 建立类型到特征的映射字典

- 实现自动维度检测与填充

- 建议使用特征哈希技巧处理高维稀疏特征

训练优化建议:

1

2

3

4

5实验配置:

| 批次大小 | 学习率 | 正则化项 | 效果评估 |

|---------|--------|----------|---------|

| 256 | 1e-3 | L2+DropEdge | 最佳 |

| 512 | 5e-4 | 仅Dropout | 次优 |常见陷阱规避:

- ❌ 直接拼接异构特征导致维度爆炸

- ✅ 采用渐进式特征融合策略

- ❌ 忽略节点类型编码的重要性

- ✅ 使用可学习的类型编码向量

四、典型应用案例

学术引用网络分析:

- 节点类型:作者/论文/期刊

- 特征加载方案:

1

2

3

4

5{

"author": ["h-index", "领域向量"],

"paper": ["文本嵌入", "引文数"],

"venue": ["影响因子", "主题分布"]

} - 使用的融合技术:三层注意力聚合(节点级→类型级→图级)

五、未来研究方向

- 自适应特征投影矩阵学习

- 基于强化学习的特征加载策略

- 异构特征的增量学习方法

- 面向超大规模图的特征缓存机制

参考文献

异构图神经网络节点维度不一致解决方案

一、核心解决思路分类

graph TD

A[维度不一致解决方案] --> B[特征空间映射]

A --> C[特征填充扩展]

A --> D[特征压缩编码]

A --> E[混合式策略]

二、具体技术方案详解

1. 特征空间投影法(Feature Space Projection)

实现原理:

1 | class TypeSpecificProjection(nn.Module): |

技术变体:

- 共享基底投影:投影层共享部分底层参数

1

2shared_base = nn.Linear(1024, 256)

# 不同类型使用共享基底后的不同头部分支 - 多目标投影:同时映射到多个公共空间

1

2

3

4multi_proj = {

'author': [nn.Linear(100, 64), nn.Linear(200, 64)],

'paper': [nn.Linear(300, 64)]

}

优势:

- 保留类型特定特征表达

- 支持端到端训练优化

- 兼容不同特征格式(连续/离散)

缺陷:

- 需要先验知识确定公共维度

- 信息损失风险(尤其原始维度差异过大时)

2. 智能填充法(Smart Padding)

核心技术:

graph LR

A[原始特征] --> B[维度分析]

B --> C

C -->|是| D[作为基准维度]

C -->|否| E[查找当前batch最大维度]

D --> F[动态补零机制]

E --> F

进阶策略:

| 策略类型 | 实现方法 | 适用场景 |

|---|---|---|

| 均值填充 | 用该特征列的均值补位 | 数值型特征 |

| 噪声填充 | 添加高斯噪声替代零填充 | 防止模型学习零值模式 |

| 注意力掩码 | 同时生成填充位置的注意力掩码 | Transformer架构 |

| 稀疏矩阵存储 | 采用COO格式存储非零项 | 极高位稀疏特征 |

工程实践:

1 | def smart_padding(features, pad_value=0): |

3. 动态特征选择法(Dynamic Feature Selection)

实现框架:

graph TB

A[原始高维特征] --> B[重要性评估]

B --> Cfalse

C -->|是| D[特征裁剪]

C -->|否| E[全量保留]

D --> F[自适应选择]

F --> G[投影到公共空间]

关键技术点:

- 重要性评估器:

1

2

3

4

5

6# 基于梯度的重要性评估

grad_importance = torch.autograd.grad(

outputs=loss,

inputs=features,

retain_graph=True

) - L0正则化选择:

1

2

3

4

5

6

7

8class L0Selector(nn.Module):

def __init__(self, input_dim):

self.z = nn.Parameter(torch.randn(input_dim))

self.temp = 0.1

def forward(self, x):

gates = gumbel_sigmoid(self.z, self.temp)

return x * gates

4. 特征解耦表示法(Disentangled Representation)

三步处理流程:

类型属性解耦:

1

2type_specific = type_encoder(type_id)

feature_generic = base_encoder(raw_feat)公共因子提取:

1

2

3

4

5common_factor = attention(

query=type_specific,

key=feature_generic,

value=feature_generic

)动态维度重组:

1

2

3

4

5final_feat = torch.cat([

common_factor,

feature_generic[:, :cfg.dim],

type_specific

], dim=1)

结构优势:

- 显式分离特征中的通用/类型专用分量

- 自动适应不同类型的最优维度配置

三、方法对比评估

| 方法 | 维度差异容忍度 | 计算复杂度 | 模型表达能力 | 训练稳定性 |

|---|---|---|---|---|

| 固定投影映射 | ★★☆ | ●●●○○ | ●●○○○ | ●●●●○ |

| 自适应填充 | ★★★★ | ●●○○○ | ●●○○○ | ●●●○○ |

| 动态特征选择 | ★★☆ | ●●●●○ | ●●●●○ | ●●○○○ |

| 解耦表示 | ★★★★☆ | ●●●●○ | ●●●●● | ●●●○○ |

| 混合式策略 | ★★★★★ | ●●●●● | ●●●●● | ●●●●○ |

(●表示程度,5个为最高)

四、典型应用场景示例

案例1:学术网络建模

1 | // 节点维度配置 |

案例2:电商异构网络

1 | # 动态维度处理流程 |

五、前沿进展展望

元学习投影矩阵:

1

2

3

4

5

6

7class MetaProjection(nn.Module):

def __init__(self, meta_network):

self.meta_net = meta_network # 生成投影矩阵参数

def forward(self, type_embedding, raw_feat):

W = self.meta_net(type_embedding)

return torch.matmul(raw_feat, W)神经架构搜索(NAS):

graph LR A[维度配置空间] --> B{NAS控制器} B --> C[生成候选架构] C --> D[性能评估] D -->|反馈| B量子化表示学习:

- 将特征映射到量子态空间

- 利用量子纠缠效应处理维度差异

参考文献

- Dynamic Feature Selection for HGNN - KDD’23

- Disentangled Graph Neural Networks

- Adaptive Projection Learning - ICLR’24

- Sparse Heterogeneous Graph Representation

注:以上方案需结合实际场景进行选择,推荐在工程实践中建立维度差异评估矩阵:

当 $\text{Dim_diff} > 3$ 时建议采用混合式策略。

附录

References

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来源 EpsilonZ's Blog!